Сайт JINR-LCG2 обеспечивает функционирование :

- вычислительного комплекса,

- системы хранения данных ,

- GRID системы,

- сервиса передачи данных,

- распределенных вычислительных систем управления,

- информационного сервиса (мониторинг серверов, хранилищ, передачи данных; информационных сайтов).

Для запуска задач на обработку данных используется менеджер рабочей нагрузки Slurm. В грид-среде используется Advanced Resource Connector (ARC) — промежуточное ПО для грид-вычислений. Оно обеспечивает общий интерфейс для передачи вычислительных задач различным распределенным вычислительным системам и может включать грид-инфраструктуры различного размера и сложности.

В качестве основных систем хранения данных используются системы dCache и EOS. Для домашних директорий пользователей — система хранения afs и cvmfs — для хранения ПО проектов (система распределённого доступа и организации версий ПО коллабораций и групп пользователей cvmfs — для хранения ПО проектов) .

Вычислительный комплекс ( CE):

- Интерактивный кластер lxpub [01-05] .jinr.ru

- Пользовательский интерфейс lxui[01-04].jinr.ru (шлюз для внешних подключений)

- Вычислительная ферма.

2025Q1-Q4:

485 hosts 10356 cores 166788.4 HEP-SPEC06 16.11 HEP-SPEC06 average per core

Системы хранения (SE):

2025Q3:

EOS: 20445.18 TB EOS MPD: 7030.71 TB EOS SPD: 7030.71 TB EOS ALICE: 1527.77 TB AFS: ~12.5TB (пользовательские директории) CVMFS: 140 TB-3 машины: 1 stratum0, 2 stratum1, 2 squid servers cache CVMFS dCache : SE disks = 4845.52 TB for CMS: 2419.91 TB for ATLAS: 2425.61 TB EOSCTA 11PB Local & EGI @ dcache2 Total: 256.91 TB - Ликвидирован по требованию инженерной службы.

2025Q1:

EOS: 20230.69 TB (данные проектов и пользователей); MPD EOS: 7030.71 TB; EOS-CTA: 11 PB (данные коллабораций, проектов); EOS: ALICE 1527.79 TB; dcache: 5047.56 TB (ATLAS+CMS=4847.82 TB Local&EGI 199.74 TB); afs: 12.5 TB (user home directories, workspaces); CVMFS: 140TB (хранение версий ПО коллабораций ) Ленточный робот: 91.5 PB

Программное Обеспечение:

2025Q3-Q4:

Scientific Linux 7.9 и Alma Linux 9.6 EOS 5.2.32 dCache 8.2, EOSCTA cvmfs openafs SLURM 25.05.3 VOMS Alice VObox grid UMD4 + EPEL (currentversion) UMD4/5 + EPEL (currentversion) ARC-CE

NICA: FairSoft FairRoot MPDroot

2025Q2:

Поддержка дистрибутива ОС RHEL7 и клонов — SL7, SLC7, Centos7 закончилась. На большинстве машин ЦИВК (Тир2, Тир1) мы переходим на ОС Alma Linux 9. Эта ОС является почти полным клоном RHEL9.

2025Q1:

CentOS Scientific Linux release 7.9, AlmaLinux 9 (eos,некоторые wns ), EOS, cvmfs, openafs, slurm, VOMS, UMD, ARC-CE, RUCIO, ALICE VObox, WLCG standard program stack, BDII top, BDII site, glite, XROOTD, GCC, C++, GNU Fortran, dCache, Enstore CTA

==========================================================================================================================================

2023-2024:

Запуск задач на обработку данных эксперимента CMS осуществляется 16-ти ядерным пилотами и для них доступны все вычислительные ресурсы. Используется менеджер рабочей нагрузки Slurm. В грид-среде используется Advanced Resource Connector (ARC) — промежуточное ПО для грид-вычислений. Оно обеспечивает общий интерфейс для передачи вычислительных задач различным распределенным вычислительным системам и может включать грид-инфраструктуры различного размера и сложности.

В качестве основных систем хранения данных используются системы dCache и EOS, dCache-Enstore, кроме того система хранения afs — для домашних директорий пользователей, cvmfs — для хранения ПО проектов (система распределённого доступа и организации версий ПО коллабораций и групп пользователей cvmfs — для хранения ПО проектов) .

2024 году выполнен большой объем работ по переходу на операционную систему (ОС) AlmaLinux 9 в связи с окончанием жизненного цикла ОС СentOS 7. Выполнен ряд работ по эксплуатации и развитию системы хранения данных dCache-Enstore. Значительные работы выполнены по модификации Enstore. В их числе конверсия кода с python2 на python3, организация параллельного выполнение запросов на монтирование / размонтирование лент в магнитофонах, что значительно улучшило время этих операций, повышение пропускной способности обработки большого потока запросов на передачу данных.

2023Q1-Q4:

Total:

485 hosts

10356 cores

166788.4 HEP-SPEC06 a total performance

16.11 HEP-SPEC06 average per core

Системы хранения (SE):

EOS: 2023Q4=23328.10 TB; 2023Q3=22203.82 TB; 2023Q2=21829.01 TB; 2023Q1=16582.35 TB; ALICE @ EOS Total: 1653.24 TB EOSCTA: 2023Q3=11PB AFS: ~12.5 TB (user home directories, workspaces) CVMFS: 140TB; 3 machines: 1 stratum0, 2 stratum1, 2 squid servers cache CVMFS; (VOs: NICA (MPD, B @ MN, SPD), dstau, er, jjnano, juno, baikalgvd....). dCache 2023Q4 : for ATLAS:1939.25 TB for CMS: 1994.36 TB Local & EGI @ dcache2 Total: 199.74

2023: Удалены 8 старых дисковых серверов, добавлены 4 новых DELL R740 по 300 ТБ каждый. Диск SE имеет 4 сервера; в EOS — 28.

2023Q2: dCache — Добавили: 2 сервера ( Qtech QSRV-462402_3) = ~0.68 PB; EOS — Добавили: 20 серверов (Qtech QSRV-462402_4) . Всего на 2023Q2 EOS = 22.353 PB

Программное Обеспечение:

2023 Q1: ОС: Scientific Linux release 7.9. EOS 5.1.9 (постоянно меняется) dCache 8.2 Enstore 6.3 or tape robots SPECall_cpp2006 with 32-bit binaries SPEC2006 version 1.1 BATCH: Slurm 20.11 with adaptation to kerberos and AFS grid UMD4 + EPEL, актуальные версии ALICE VObox ARC-CE FairSoft FairRoot MPDroot

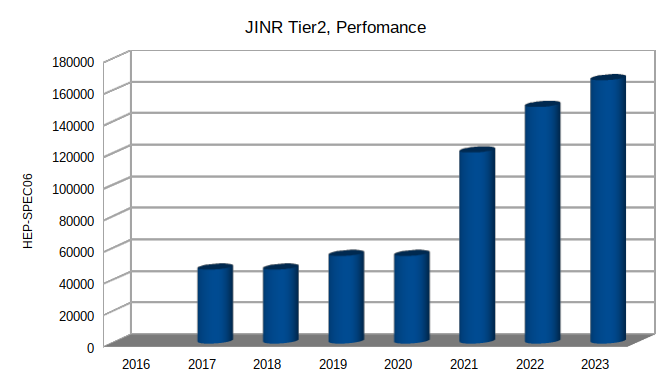

2017-2023Q1:

Развитие ресурсов :

CE: 2017 cores=3640; 46867 HEP-Spec06 2018 cores=4128; 55489 HEP-Spec06 2019 cores=4128; 55489 HEP-Spec06 2020 cores=4128; 55489 HEP-Spec06 2021 cores=7700; 121077 HEP-Spec06 2022 cores=9272; 149939 HEP-Spec06 2023 cores=10356; 166788 HEP-Spec06

EOS: 2019=4 PB; 2020=7.198 PB; 2021=15.598 PB; 2022=16.586 PB; 2023Q1=16582.35 TB; 2023Q2=21829.01 TB; 2023Q3=22203.82 TB; 2023Q4=23328.10 TB;

dCache disks: 2018=2070ТB+147TB; 2019=2147 TB; 2020=9700 TB; 2021Q1=10686 TB; 2021Q4=11371 TB; 2022Q1=11371 TB; 2022Q4=11336 TB; 2023Q3=12506.24 TB;

CE: 2023: 485 hosts 10356 cores 166788.4 HEP-SPEC06 a total performance 16.11 HEP-SPEC06 2022: Total: 9272 cores 149938.7 HEP-SPEC06 a total performance 37484.7 HEP-kSI2k a performance per core 2021Q3: Total: 7700 cores 121076.99 HEP-SPEC06 a total performance 30269.25 HEP-kSI2k performance per core 2019 Total: 4128 cores/slots 55488.92 HEP-SPEC06 13872.23 HEP-kSI2k

Архив:

Инфраструктура и Сервисы сайта Тир2 (JINR-LCG2) 2024

Инфраструктура и Сервисы сайта Тир2 (JINR-LCG2) 2023

Инфраструктура и Сервисы сайта Тир2 (JINR-LCG2) 2021-22

Инфраструктура и Сервисы сайта Тир2 (JINR-LCG2) 2020

Инфраструктура и Сервисы сайта Тир2 (JINR-LCG2) 2019

Инфраструктура сайта JINR-LCG2 и сервисы , 2018

Инфраструктура сайта JINR-LCG2 и сервисы , 2017

Инфраструктура сайта JINR-LCG2 и сервисы , 2016