2023:

Сайт JINR-LCG2 обеспечивает функционирование :

- вычислительного комплекса,

- системы хранения данных ,

- GRID системы,

- сервиса передачи данных,

- распределенных вычислительных систем управления,

- информационного сервиса (мониторинг серверов, хранилищ, передачи данных; информационных сайтов).

Вычислительный комплекс ( CE):

- Интерактивный кластер lxpub [01-05] .jinr.ru

- Пользовательский интерфейс lxui[01-04].jinr.ru (шлюз для внешних подключений)

- Вычислительная ферма.

2023Q1-Q4: Total: 485 hosts 10356 cores 166788.4 HEP-SPEC06 a total performance 16.11 HEP-SPEC06 average per core

Системы хранения (SE):

EOS: 2023Q4=23328.10 TB; 2023Q3=22203.82 TB; 2023Q2=21829.01 TB; 2023Q1=16582.35 TB; ALICE @ EOS Total: 1653.24 TB EOSCTA: 2023Q3=10PB AFS: ~12.5 TB (user home directories, workspaces) CVMFS: 140TB; 3 machines: 1 stratum0, 2 stratum1, 2 squid servers cache CVMFS; (VOs: NICA (MPD, B @ MN, SPD), dstau, er, jjnano, juno, baikalgvd....). dCache 2023Q4 : for ATLAS:1939.25 TB for CMS: 1994.36 TB Local & EGI @ dcache2 Total: 199.74

2023: Удалены 8 старых дисковых серверов, добавлены 4 новых DELL R740 по 300 ТБ каждый. Диск SE имеет 4 сервера; в EOS — 28.

2023Q2: dCache — Добавили: 2 сервера ( Qtech QSRV-462402_3) = ~0.68 PB; EOS — Добавили: 20 серверов (Qtech QSRV-462402_4) . Всего на 2023Q2 EOS = 22.353 PB

Программное Обеспечение:

2023 Q1: ОС: Scientific Linux release 7.9. EOS 5.1.9 (постоянно меняется) dCache 8.2 Enstore 6.3 or tape robots SPECall_cpp2006 with 32-bit binaries SPEC2006 version 1.1 BATCH: Slurm 20.11 with adaptation to kerberos and AFS grid UMD4 + EPEL, актуальные версии ALICE VObox ARC-CE FairSoft FairRoot MPDroot

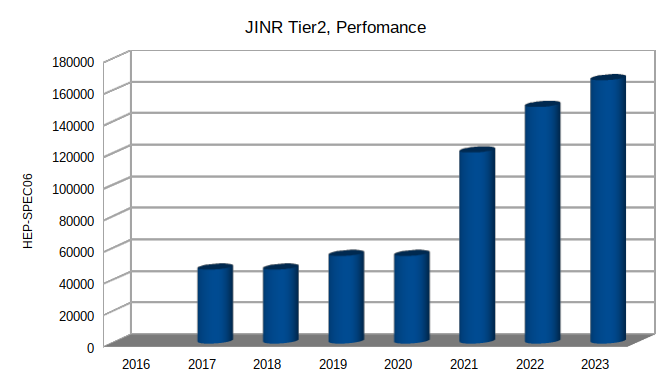

2017-2023Q1:

Развитие ресурсов :

CE: 2017 cores=3640; 46867 HEP-Spec06 2018 cores=4128; 55489 HEP-Spec06 2019 cores=4128; 55489 HEP-Spec06 2020 cores=4128; 55489 HEP-Spec06 2021 cores=7700; 121077 HEP-Spec06 2022 cores=9272; 149939 HEP-Spec06 2023 cores=10356; 166788 HEP-Spec06

EOS: 2019=4 PB; 2020=7.198 PB; 2021=15.598 PB; 2022=16.586 PB; 2023Q1=16582.35 TB; 2023Q2=21829.01 TB; 2023Q3=22203.82 TB; 2023Q4=23328.10 TB;

dCache disks: 2018=2070ТB+147TB; 2019=2147 TB; 2020=9700 TB; 2021Q1=10686 TB; 2021Q4=11371 TB; 2022Q1=11371 TB; 2022Q4=11336 TB; 2023Q3=12506.24 TB;

CE: 2023: 485 hosts 10356 cores 166788.4 HEP-SPEC06 a total performance 16.11 HEP-SPEC06 2022: Total: 9272 cores 149938.7 HEP-SPEC06 a total performance 37484.7 HEP-kSI2k a performance per core 2021Q3: Total: 7700 cores 121076.99 HEP-SPEC06 a total performance 30269.25 HEP-kSI2k performance per core 2019 Total: 4128 cores/slots 55488.92 HEP-SPEC06 13872.23 HEP-kSI2k

Архив:

Инфраструктура и Сервисы сайта Тир2 (JINR-LCG2) 2023

Инфраструктура и Сервисы сайта Тир2 (JINR-LCG2) 2021-22

Инфраструктура и Сервисы сайта Тир2 (JINR-LCG2) 2020

Инфраструктура и Сервисы сайта Тир2 (JINR-LCG2) 2019

Инфраструктура сайта JINR-LCG2 и сервисы , 2018

Инфраструктура сайта JINR-LCG2 и сервисы , 2017

Инфраструктура сайта JINR-LCG2 и сервисы , 2016

2020.

Конфигурация фермы Тир2 (JINR-LCG2):

1) Изменен batch сервер на тип Slurm. Работает и используется CE.

2) Изменен Computing Element (CE) для WLCG тип - ARC6.

(CREAM-CE больше не поддерживается центральным сервисом

запуска задач).

3) ферма переведена на систему Scientific Linux release 7.

4) Добавлен новый ленточный робот (TS4500).

5) PhEDEx заменен на RUCIO.

6) Подключены новые серверы EOS.

7) Новый пользовательский интерфейс lxui[01-04].jinr.ru в качестве шлюза для внешних подключений

8) Увеличено пространство для пользователей /scrc

Вычислительные ресурсы (CE):

- Интерактивный кластер: lxpub[01-05].jinr.ru

- Пользовательский интерфейс lxui[01-04].jinr.ru (шлюз для внешних подключений)

- Вычислительные фермы :

ферма общего назначения,

ферма для экспериментов LHC,

кластер для NICA,MPD,BM@N lxmpd-ui.jinr.ru )

Всего : 248 вычислительных узлов( WNs) , 4128 ядер (cores/slots) , 55489 HS06.

Системы Хранения (SE):

dCache : (только для ВО ATLAS,CMS )

дисковые сервера 9700 TB

ленточные роботы : 3003TB; IBM TS3500(1600TB) + IBM T45500(1600TB) IBM TS3500(1.16PB) + IBM T45500(1.6PB)

EOS: 7.198 PB (хранение данных)

CVMFS : 2 машины - 2x70 TB h/w RAID1 (VOs: NICA (MPD, B@MN, SPD) (Для ПО проектов NICA(MPD, B@MN, SPD), dstau, er, jjnano, juno, baikalgvd)

afs: 7 серверов, ~12.5 TB (Домашние директории пользователей и и проектные пространства)

2019 : Инфраструктура сайта JINR-LCG2 :

Вычислительная ферма.

состоит из вычислительных узлов ( 2 x CPU Xeon, 4-28 cores per CPU, E54XX, X65XX, X56XX, ES-26XX v3/4, 2-4GB RAM per core) моделей SuperMicro Blade, SuperMicroTwin2, Dell FX. Cуммарно мы располагаем :

2019 : 4128 cores/slots 55488.92 HEP-SPEC06 13872.23 HEP-kSI2k

Интерактивный кластер.

Для разработки собственного ПО и других нужд пользователей ОИЯИ установлены Пять 64-х битных машин с интерактивным доступом пользователей.

CVMFS (/cvmfs) : 2 machines: 2x70TB h/w RAID1.

Введена в эксплуатацию подсистема подсистема CVMFS которая служит для развертывания больших пакетов программного обеспечения коллабораций работающих в WLCG. Используется для запуска приложений обработки данных экспериментов. B настоящее время у нас уже хранятся версии ПО NICA, BM@N, MPD (/cvmfs/nica, /cvmfs/…) и занимают 140TB (до мая 2019 было 9.5 ГБ) .

OSG HT-CONDOR

Вычислительный элемент OSG HT-CONDOR введен в инфрастуктуру сайта Tier2 для VO STAR. Аутентификации осуществляется через "long lived grid" прокси-сервер. Это позволяет VO STAR обрабатывать данные на нашем сайте Tier2 с эффективностью более 90%.

Программное Обеспечение :

- OS: Scientific Linux release 6.10 x86_64

- BATCH : Torque 4.2.10 (home made)

- Maui 3.3.2 (home made)

- CMS Phedex

- ALICE VObox

- dCache-5.2

- EOS aquamarine

- CVMFS

WLCG

Для обслуживания сайта WLCG в ОИЯИ (сайт — отдельный кластер в распределенной среде WLCG) и других международных коллабораций, установлено 22 сервера с системой gLite (ПО промежуточного уровня WLCG). Кроме функций поддержки работы самого сайта JINR-LCG2, часть серверов реализуют важные сервисы и функции поддержки Российского сегмента проекта WLCG.

Стандартный стек программ WLCG:

• 2 x CREAM,

• 4 x ARGUS,

• BDII top, BDII site,

• APEL parsers, APEL publisher,

• EMI-UI, 220 x EMI-WN + gLExec-wn,

• 4 x FTS3,

• LFC,

• WMS,

• L & B,

• glite-proxyrenewal

В ЛИТ ОИЯИ был проведен ряд работ по применению грид-технологий для обработки данных экспериментов, не относящихся к LHC: COMPASS, NICA MPD.

Для эксперимента COMPASS на SPS была разработана система управления обработкой данных , которая обеспечивает автоматическую обработку данных и управление на различных типах вычислительных ресурсов.

DIRAC Interware использовался для интеграции распределенных гетерогенных вычислительных ресурсов и ресурсов хранения для моделирования экспериментов NICA MPD.

Более 50 000 работ по моделированию методом Монте-Карло в эксперименте NICA MPD были выполнены на Tier1 и Tier2 ОИЯИ с использованием DIRAC.

В 2019 в OИЯИ Tier2 добавлены в виртуальные организации:

ILC (WLCG http://www.linearcollider.org),

MPD (JINR NICA),

BM@N (JINR NICA),

COMPASS (WLCG CERN).

Для виртуальной организации JUNO на Tier2 будет установлено и настроено несколько сервисов:

- CE JUNO — будет разрешено запускать задачи в ферме JINR/Tier2

- VOMS сервер, зеркало основного VOMS в Китае;

- CVMSF stratum-1 сервер, для поддержки, доступ к репозиториям ПО JUNO в Китае.

В настоящее время вычислительными ресурсами, доступными для совместной работы, являются пакетная служба CERN, вычислительный центр ОИЯИ и суперкомпьютер Frontera техасского суперкомпьютерного центра.

Системы хранения.

- dCache.

Основной системой хранения больших объемов информации в ЦИВК ОИЯИ служит аппаратно-программный комплекс dCache. Для сайта Tier2:

1-ый диск для 2-х виртуальных организаций LHC CMS и ATLAS ( Typically Supermicro and DELL) 2PB

2-ий диск для EGI Vos & локальных пользователей : 147TB

- EOS (4PB)

EOS предназначена для хранения и доступа к большим массивам информации, в том числе и для распределённой коллективной генерации данных, сохранения “сырых” данных установок, преобразования и анализа данных. В настоящее время наш EOS имеет емкость 4PB. Является общим для Tier1 и Tier2. Для хранения сырых данных на текущий момент используют эксперименты BM@n ~81TB, MPD ~84GB данных моделирования,ALICE 712TB.

- XRootD (40GB)

XRootD - это полностью универсальный набор для быстрого, с малым временем ожидания и масштабируемого доступа к данным, который может обслуживать любые типы данных, организованные в виде иерархического пространства имен, подобного файловой системе, на основе концепции каталога. Предназначен для VO PANDA.

- AFS (Andrew File System).

Служба AFS (Andrew File System) предоставляет сетевое хранилище файлов для пользователей, в частности домашних каталогов и пространств проектов. В ЦИВК установлено 7 серверов AFS . Общее пространство AFS составляет ~12.5 TB

- NFS

В ЦИВК установлено 5 серверов NFS . Общее пространство NFS составляет ~11 TB

В состав ЦИВК входит несколько серверов пользователей и

служб ОИЯИ:

batch, WWW, БД mysql и Oracle; e-mail; DNS,мониторинг Nagios, WLCG и другие. Эти серверы работают с основном на 64-х битных аппаратных Xeon и Opteron.

Программное обеспечение систем хранения :

- dCache-3.2

- Enstore 4.2.2 for tape robot.

- EOS aquamarine

- cvmfs

- CMS Phedex

- ALICE Vobox

- UMI-4

- openafs

- XROOTD 3 —->EOS for ALICE

- WLCG —>UMI-4 for ALICE

- WLCG grid–environment for the VOs.

Monitoring.

Для обеспечения правильной и надежной работы оборудования компьютерного комплекса и своевременного предоставления актуальной информации о его работе была разработана специальная система мониторинга.

Мониторинг позволяет контролировать системы климат-контроля и энергоснабжения, локальное сетевое оборудование, телекоммуникационные линии и вычислительные узлы, выполняемые задания, системы хранения на дисках и ленте и отслеживать работу всей грид-инфраструктуры ОИЯИ в режиме реального времени.

Количество узлов, включенных в мониторинг, составляет более 1200. Для обеспечения такого обширного мониторинга используется система кластерного мониторинга, основанная на программном обеспечении Icinga2. Визуализация осуществляется с помощью Grafana и NagVis.

Сеть и телекоммуникация.

Одним из наиболее важных компонентов ЦИВК ОИЯИ обеспечивающих доступ к ресурсам и возможность работы с большими данными, является сетевая инфраструктура. В настоящее время в ЦИВК :

-

Local Area Nertwork (LAN) 10Gbps, запланировано обновление до 100Gbps

-

Wide Area Network (WAN) 100Gbps, 2x10Gbps , запланировано обновление WAN до 2x100Gbps.